ユーザーテストの未来――言葉の裏を読む、次世代UXリサーチの探求 中編:心は読めるか?――手に汗握る「生体テスト」の世界へようこそ!

言葉にならない声を聴く

前回の記事では、ユーザーの言葉やアンケートの数値がいかに曖昧で、私たちを惑わせるか、というお話をしました。

「人は自分でも自分のことが分からない」という、ちょっと切ない事実にも触れました。

言葉が「二次情報」なら、私たちは何を頼りにデザインすればいいのか? その答えのヒントが、身体が発する「一次情報」にあります。

今回は、その情報をキャッチする「生体テスト」の具体的な世界にご案内します!

あなたの「ドキドキ」可視化します

生体テストと聞くと、なんだか難しそうですが、実は私たちの身近な感覚と繋がっています。それは私たちが普段人の顔色をみたり、仕草や視線の動きをみたりして、相手の状況を推察するのと同じことです。

また、自分自身で恥ずかしくて自分の顔が熱くなったり、心臓がドキドキしたりなど、状況の変化を察することもできます。

生体テストはそれらの身体変化を観測し、心理状態を分析する試みです。

現在、よく用いられる生体テストには以下のようなものがあります。

- アイトラッキング: 「見てほしいバナーが見られているか」「どこで迷っているか」「どこが一番見られているか」などについて、ユーザーの視線の動きを追いかけることで可視化し調査する手法です。

- 心拍(Heart Rate): 心拍を計測することで、まさに「ドキドキ」を可視化できます。緊張や興奮、面白いコンテンツに触れた時の高揚感をキャッチします。

- 皮膚電気活動(Sweat Response): 発汗反応を計測します。いわゆる 「手に汗握る」状態のように、集中したり、ストレスを感じたりすると交感神経が活発になり、足や手のひらに微量の汗をかきます。意外にもリアルタイムな状態変化を取得することができます。

- 瞳孔径・まばたき頻度:瞳孔の広がりや、まばたきの頻度には興奮や覚醒、注意レベルが反映されます。それを利用したテストが可能です。

- 表情分析:顔の筋肉の動きや表情によって、喜怒哀楽などの感情反応、微細な心情変化を計測することができます。

- 脳波(EEG): α波(リラックス)やβ波(集中)など、脳の活動状態を直接計測します。ユーザーの集中度やストレス、さらには感情まで予測しようという研究が進んでいます。

- 脳画像(fMRI等):EEGよりもより詳細に脳の状態を可視化することができます。そのため、高度な認知機能の解析が可能で、最新のニュースでは人が見た夢を判別する研究などが行われています。ただし情報の取得が数秒単位なのでリアルタイムでのテストには向いていません。(※1)

技術の進歩により夢のような解析が可能になってきていますが、fMRIを用いたテストなどは、高額でまだ一般的なテストとは言えません。

しかし、それ以外のテストに関しては機材自体の価格も下がり、現実的な費用感で利用することもできます。

そのため、これらのセンサーは、ゲーム開発や製品デザインの現場で、すでに強力な武器として使われています。

それによって従来のアンケートでは決して得られなかった、ユーザーの「本音」を明らかにすることが可能になってきています。

感情を測る「新しい物差し」の正体

例えば、大ヒットホラーゲーム『バイオハザード7』を開発したカプコンの事例は有名です。

そこでは、プレイヤーの「恐怖」そのものをデータ化する試みが行われました。

テストプレイヤーに心拍計を装着してもらい、ゲームプレイ中の心拍数の変化を記録しました。(※2)

その結果、意外な事実がわかりました。

プレイヤーが最も心拍数を上昇させたのは、敵が突然飛び出してくる「ジャンプスケア」の瞬間だけではなかったのです。

むしろ、何も起こらない静寂の中、廊下の角を曲がろうとする直前など、「何かが起こるかもしれない」という予期不安によって心拍数がじわじわと上昇し、精神的な負荷がピークに達することがデータで証明されました。

得られたデータによって、「恐怖の物差し」とも言える客観的なデータを元に、「ここの演出は怖がらせすぎているから少し抑えよう」「この静寂はもっと長くして、プレイヤーの緊張感を高めよう」といった、ミリ単位での恐怖演出の調整を行うことが可能になります。

ただ「怖かった」という言語化の際に編集された主観的な二次情報だけでなく、心拍数の波形という一次情報から、身体の声を読み取りプレイヤーを絶叫させる体験を作り上げることができるという訳です。

一方、自動車業界では、より野心的な試みが行われています。

スウェーデンの自動車メーカー、ボルボは、自社のコンセプトカーのデザイン評価に、脳波(EEG)測定を導入しました。(※3)

彼らが知りたかったのは、「運転中のストレス」といった機能的な側面だけではありません。

「このデザインは、本当にかっこいいのか?」という、極めて主観的で、感性に属する問いの答えでした。

ボルボは、被験者に脳波計を装着してもらい、新しい車のデザイン画像を次々と見せました。

そして、人々が「魅力的だ」「新しい」と感じた時に現れる特有の脳波のパターンを分析し、「かっこよさ」を数値化しようと試みたのです。

デザイナーの「これがクールだろう!」という感性と、ユーザーが脳レベルで「クールだ!」と感じる反応。

その二つをデータで結びつけようという、野心的な試みの一例です。

このようなアプローチが進化すれば、将来、私たちの「好き」という感情が、デザインの意思決定を直接左右する時代が来るのかもしれません。

このように、生体テストは、従来のテストでは得られなかった、ユーザーの一次情報を取得し、生の反応を得ようとする強力なアプローチなのです。

ついに開いた生体テストへの扉

KLabでは以前よりユーザーテスト環境の構築に力を入れ、様々なテスト手法を試みていました。

社外に頼りきりになるのではなく、自社でも小規模なテストが実施できるようにインタビューの手法や正しいアンケート方法など自分たちでも調査し、得られたデータをどのように活用し分析するのかなどに取り組んでいました。

結果、 テストについて知ることで、他社にテストを依頼する際にも、どのようなテストを実施するべきかなど、テスト自体の品質をあげることができることもわかってきました。

そのような中で、従来のユーザーテストから得られる情報に限界があることを知り、より精度が高い、生体テストにも注目してきました。

ただ、生体テストはハードルが高く、以前、アイトラッキングを実施した時には、分析の難易度やその費用感も含め、それを継続的に利用するという流れにはなりませんでした。

しかし、生体テストで何ができるかということについては調査を継続していました。

アイトラッキングを使ったユーザーテストでお世話になっていたトビー・テクノロジー株式会社(以下、トビー・テクノロジー)に相談したり、アイトラッキングの研究をしている大学に相談したりもしました。

そんな中、トビー・テクノロジーからのお声がけで、心拍や発汗とアイトラッキングを併用した生体テストを実際に体験をさせていただくありがたい機会をいただくことになりました。

いざ!波形の謎を解き明かせ

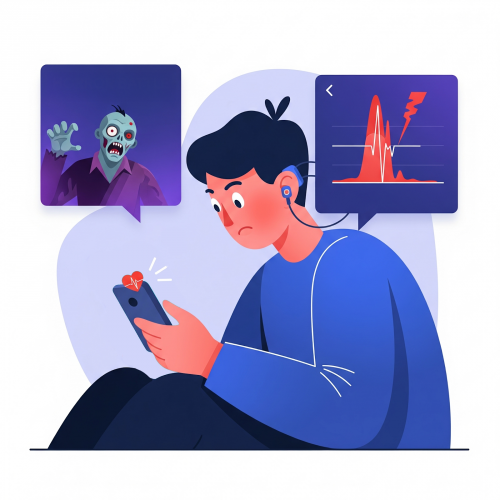

生体センサーを用いたテストには多くの機材を必要とするため、テスト当日は五反田にあるTobiiの日本法人トビー・テクノロジーにお伺いしました。

テスト被験者の同僚の頭や指にセンサーをつけ、準備完了。

同僚に後ろから「わっ!」と驚かすと、モニターの波形がピコン!と大きく振れました。

当たり前のことなのですが、「おお、これが身体の反応か!」と皆で感動しました。

(左図:赤丸部分が中止している個所/右図:心拍計のクリップを耳に付け、アイトラッカーのキャリブレーションをしている所)

しかし、ここで重要なポイントがあります。

この波形が「何を意味するのか」は、波形だけを見ていても分からない、ということです。

「ドキドキ」にも、ポジティブなワクワクと、ネガティブな緊張の2種類があるように、その波形はどちらの「ドキドキ」なのかわからないわけです。

生体テストの難しいポイントは、情報に明らかになった答えがあるわけではないということ。

それはテストによって、私たちが解読すべき謎なのです。

例えば、視覚情報と心拍や発汗の変化を同じタイムライン上に並べてみるとそこに何かしらの相関性があるはずなのですが、観察を重ね、物言わぬデータからそれを読み取っていくしかないのです。

そこで私たちはこう考えました。

体の中で起こっている反応としての一次データ、その反応から二次データとしての言葉や行動が起こっているのなら、後から、同じような状況を見せ追体験することで、もう一度、言葉や行動が同じように立ち上がってくるのではないか?

そこで、ある仮説を立てました。

「取得したアイトラッキングの映像をユーザーに見せ、ヒアリングを行うことで、リアルタイム時には発話にならなかった言葉を引き出すことができ、感情の解像度が上げることができるのでは?」

フローとしてはこうです。

テスト中はユーザーに集中してもらい、生体データを取得します。

プレイテスト終了後、録画したプレイ画面と心拍や発汗のデータの波形を見返します。

そして、波形が大きく変化したポイントや気になる点をマーキングします。

そして、動画を見ながら、マーキングしたポイントで、動画を止め、被験者に「このとき、どう感じましたか?」と尋ねるのです。

(下図:皮膚電気活動のグラフで赤い縦線が現在のタイムライン/上図:現在タイムラインでユーザーが見ている映像)

すると、リアルタイムの発話テストでは得られないような、驚くほど詳細な情報を引き出すことができました。

「あ、ここはボスの登場シーンで、すごくワクワクしました。でも、思ったより出てきたボスが弱くて、すぐに勝てちゃってガッカリしたんです」

「この画面、好きなキャラクターを選ぶ方法が分からなくて、地味にイライラしてましたね」

このように、その場での発話テストでは出てこなかったであろう、「ワクワク→ガッカリ」という感情の微細な変化や、「言葉にするほどではない小さなイライラ」を捉えることができたのです。

これは、通常の発話テストでは得られない、より詳細な感情情報であり、改善につながる宝の山です。

ハードルは高い、でも...

もちろん、生体テストのハードルはまだ高いのが現状です。専門的な機材が必要ですし、得られたデータをどう解釈するかのノウハウも確立されているわけではありません。

しかし、技術は日々進歩し、アイトラッカーの価格も劇的に下がってきていて、5年ひと昔前よりも遥かに取り組みやすくなってきています。

分析の知識は必要ではありますが、外部の会社に生体テストを含めたユーザーテストを依頼することもできるでしょう。

今はデータをどう解析するかという研究情報も公開されそれをもとに、社内でのテストもできるかもしれません。

しかし、生体テストをやる以前に、より大切なのは「何を知りたいのか」という目的を明確にすることです。

「このボス戦で、ユーザーは本当に手に汗握るのか?」 「このチュートリアルは、ストレスなく進められているか?」 テストの目的を持つことが、ユーザーテストの第一歩です。

生体センサーで得られるデータは、問いがなければただの「未知の国の言語」のようなものです。

しかも、単語の意味が分かったとしても、それが何を意味するのかはわかりません。

例えば、ユーザーの視線の滞在時間が長いポイントがあったとして、そこが見られていることは事実として理解することはできるのですが、なぜ、ユーザーがそのポイントを長く見たのかその理由は見えてきません。

そこに必要なのは、それを解釈するための課題であり、課題に対して事実を紐解くための仮説です。

それがなければデータは何も語りかけてくれません。

そして、その仮説を持つには、知識だけではなく、ユーザーに対する理解や洞察が必要になります。

そのためどうしても生体テストを十分に活かすことの難易度が上がってしまうのです。

しかし、 そこに強力な翻訳機が現れました。

そう、それが「AI」です。

これまで専門的知見がなければ、触れることができなかった生体データの解析に、今、AIによって新たな光が差し込んできています。

※1:Heeger, D. J., & Ress, D. (2002). What does fMRI tell us about neuronal activity? Nature Reviews Neuroscience, 3(2), 142-151.

※2:出典:マクロミル『ニューロリサーチ(コンセプト開発)活用事例』,出典元URL: https://www.macromill.com/service/case/004/

※3:Ahlström, M., Dahlgren, P., Johansson, L., & Sandin, P. (2006). The "Brain Car" Project: How to Measure Emotional Response to Design. Proceedings of the 13th International Conference on Human-Computer Interaction.

この方に記事を用意していただきました!

里宗 巧麻

UI・UXグループ

マネージャー

次回は、AIと融合することで、ユーザーテストがこれからどう進化していくのか? そのワクワクする未来についてお話しします。

デザインを科学する「ニューロデザインラボ」でも記事を掲載中です。

このブログについて

KLabのクリエイターがゲームを制作・運営で培った技術やノウハウを発信します。

おすすめ

合わせて読みたい

このブログについて

KLabのクリエイターがゲームを制作・運営で培った技術やノウハウを発信します。